H200

史上最强 AI芯片 NVIDIA HGX™ H200

141 GB 超大显存!带宽增加 2.4 倍

H200 拥有141GB 显存!相比之前的 H100和A100,容量几乎翻倍!

NVIDIA H200 是首款提供 HBM3e 的 GPU,借助 HBM3e,NVIDIA H200 以每秒 4.8 TB 的速度提供 141GB 显存,带宽增加 2.4 倍。

H200可以轻松加速生成式 AI 和大语言模型,同时推进 HPC 工作负载的科学计算。

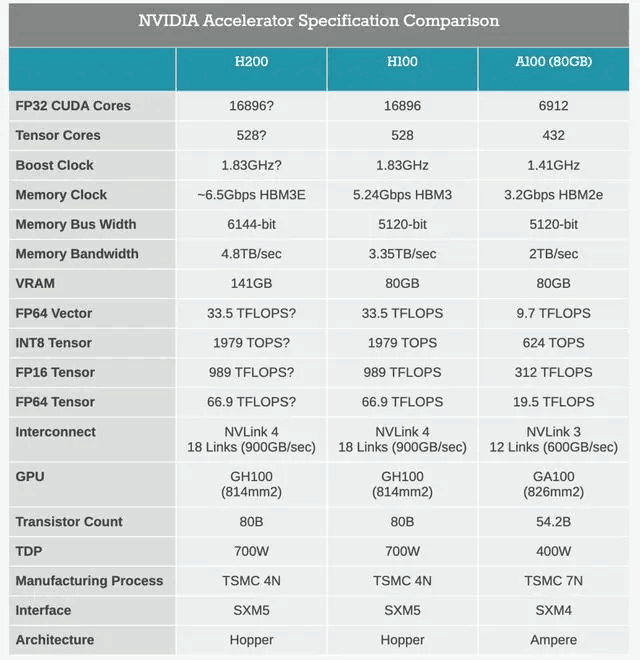

下面是H200和H100以及A100显卡的各参数对比图,可以清晰帮助大家看出H200各方面带来的提升。

兼容H100系统,轻松训练ChatGPT,Llama 2推理速度翻倍!

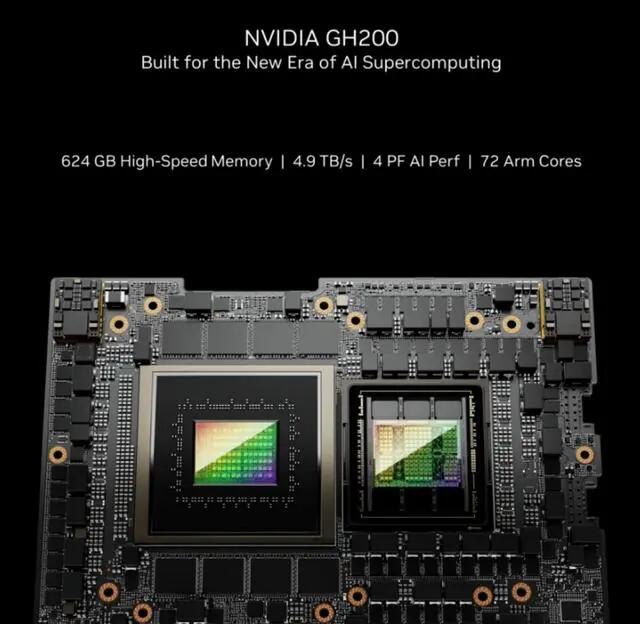

NVIDIA H200将在具有四路和八路配置的NVIDIA HGX H200服务器主板中提供,这些主板与HGX H100系统的硬件和软件兼容。它还可用于 8 月份发布的采用 HBM3e 的 NVIDIA GH200 Grace Hopper™ 超级芯片。

HGX H200 由 NVIDIA NVLink™ 和 NVSwitch™ 高速互连提供支持,可为各种应用工作负载提供最高性能,八路 HGX H200 提供超过 32 petaflops 的 FP8 深度学习计算和 1.1TB 聚合高带宽内存,可在生成式 AI 和 HPC 应用中实现最高性能。

对超过 1750 亿参数的ChatGPT等大语言模型进行训练和推理也不在话下!

具体到训练大模型方面有何提升呢?

英伟达进行了官方测试——相比 H100 ,Llama 2的推理速度几乎翻倍!。

当用H200与英伟达GraceCPU搭配使用时,就能组成性能更强的GH200 Grace Hopper超级芯片,专为应用于大型HPC和AI应用!

新一代超算要来了!

NVIDIA还宣布与 Jupiter 合作赢得了一项新的超级计算机设计。根据 EuroHPC 联合组织的订购,Jupiter 将成为由 23,762 个 GH200 节点构建的新型超级计算机。

一旦上线,Jupiter 将成为迄今为止最大的基于 Hopper 的超级计算机,并且是第一台明确(且公开)针对标准 HPC 工作负载以及已经出现的低精度张量驱动的 AI 工作负载的超级计算机。